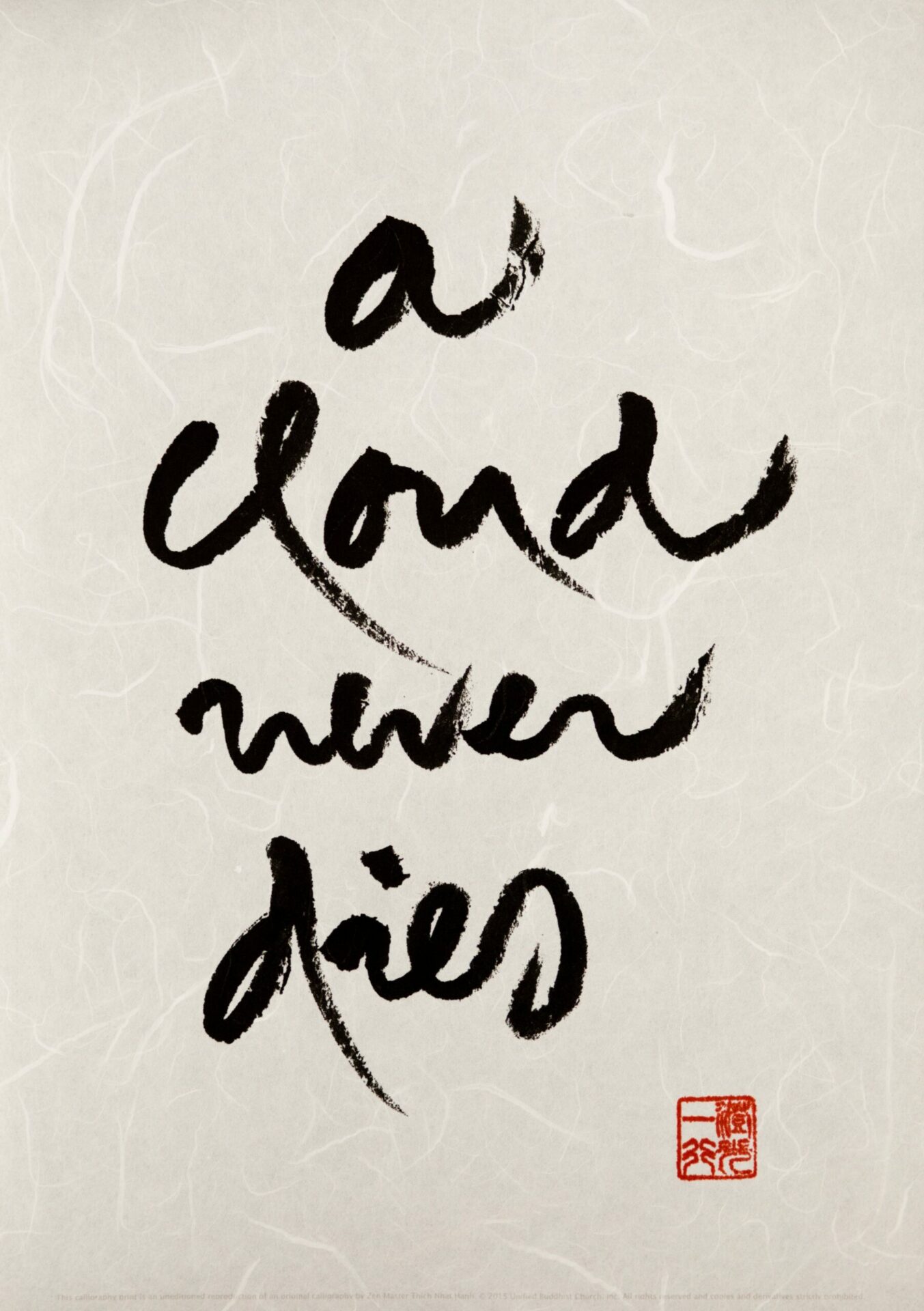

Shodo: The Quiet Art of Japanese Zen Calligraphy, Learn the Wisdom of Zen Through Traditional Brush Painting

Sato,Shozo • 3 highlights

amazon.com

respected Tanchiu Koji Terayama, director of Hitsu Zendo. The English translation of his book’s title is Zen and the Art of Calligraphy (transl. by John Stevens; Penguin Group, 1983).