Sublime

An inspiration engine for ideas

羊驼家族的开源llm狂欢就要开始了👏

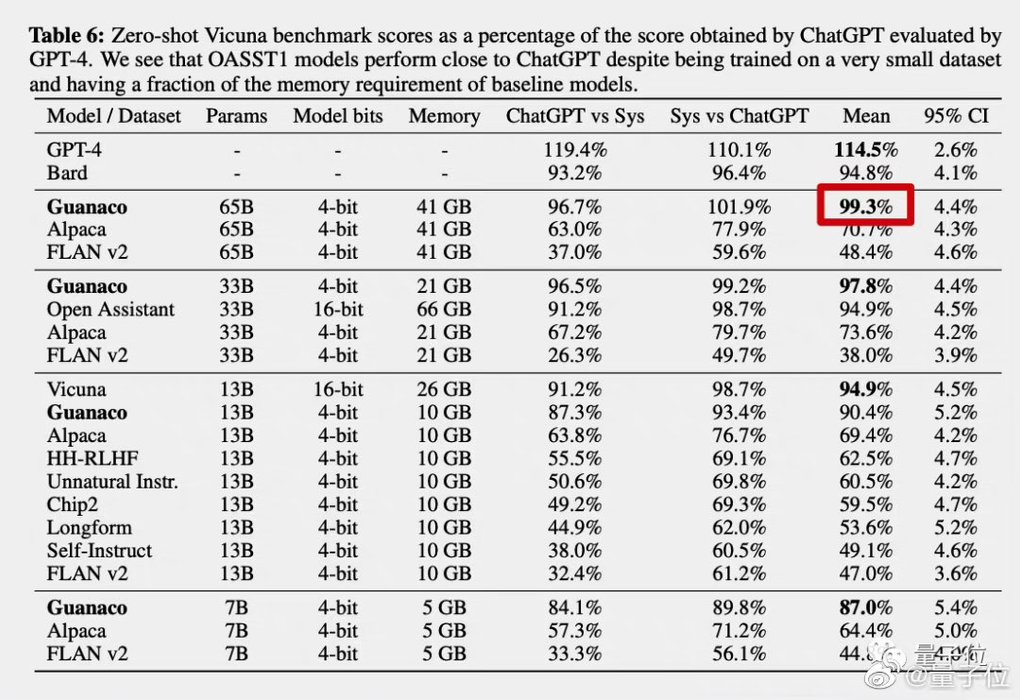

自动测试分数达到ChatGPT的99.3%,人类难以分辨两者的回答……

这是开源大模型最新成果,来自羊驼家族的又一重磅成员——华盛顿大学原驼(Guanaco)。

更关键的是,与原驼一起提出的新方法QLoRA把微调大模型的显存需求从>780GB降低到<48GB。

开源社区直接开始狂欢,相关论文成为24小时内关注度最高的AI论文。

Tamar

@tamar

Tamar Lando

@tl2000

Tamar Rodriguez

@tamarorleana

Tamara Will

@tamarawill

Amazon

Dom • 2 cards

Tami

@tami-59681148dcc049ac

cameliar

@cameliar

Solana

Tengji Zhang and • 4 cards